Как быстро проверить индексацию страниц в яндексе и google

Содержание:

- Загрузка файлов на сервер с прогрессом и докачкой

- Как проверить индексацию отдельной или всех страниц

- Дополнительные сервисы

- Индексация сайта в Яндексе

- Почему так важна проверка индексации сайта

- Robots.txt

- Зеркала

- Дублирование

- Что необходимо сделать для начала индексации нового сайта

- Semonitor

- Как сохранить метку на карте

- Проверка индексации страниц сайта в Яндексе через AddURL

- Используем панель Вебмастера

- Различия индексации сайта в Google и «Яндексе»

- Мир

- Проверка индексации

- Инструмент проверки индексации от PromoPult

- Тестируем Google

- Как управлять поисковым роботом

- Что такое апдейт?

- Заключение

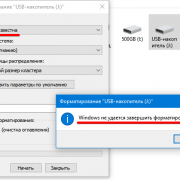

Загрузка файлов на сервер с прогрессом и докачкой

Как проверить индексацию отдельной или всех страниц

Проверка отдельной странички нужна, когда необходимо убедиться, что новый опубликованный контент успешно «замечен» поисковыми системами. Или когда вы приобрели на чужом ресурсе платную ссылку и теперь с нетерпением ждете ее индексации. Это можно сделать через:

- Ввод URL страницы в строку поиска Яндекс или Google. В случае если проблем с восприятием страницы поисковиками нет, она первой отобразится в результатах поиска.

- Уже упомянутый плагин RDS Bar.

Для проверки индексации всех страничек сайта понадобится список их адресов (URL). Для этого можно воспользоваться каким-либо генератором карт веб-ресурсов, к примеру, Sitemap Generator. Чтобы собрать только URL страниц, не забудьте внести маску ненужных адресов, например, на комментарии, в окне «Exclude Patterns». По окончании процесса следует перейти во вкладку Yahoo Map/Text, откуда скопировать сгенерированный перечень всех адресов.

Имея его на руках, индексацию всех страничек не составит труда проверить с помощью программы YCCY.ru. Просто добавьте данные в список исходных URL и выберите одну из предложенных поисковых систем: Google, Яндекс или Rambler. Нажмите кнопку «Начать Проверку» и получайте утешительные или не очень результаты.

Дополнительные сервисы

Ради интереса я решил проверить еще несколько онлайн сервисов для проверки. Они помогут проверить сайты конкурентов.

Первым я хочу посмотреть SeoGadget. Помимо простой проверки, за дополнительные деньги, здесь можно узнать проверку позиций по ключевым словам. Посмотрим для начала, как он справляется с обычной индексацией.

Сколько я ни старался, гугл проверка не осуществилась, постоянно вылезает ошибка. В Яндексе же он показывает всего 300 страниц. Эта информация далека от истины.

Далее идет pr-cy.ru. Проверка индексации входит в «Анализ сайта». Выбираем эту функцию и вводим url.

Этот ресурс более близок к реальности. Я настоятельно его рекомендую как для проверки своего проекта, так и для анализа чужих. Тут очень много полезной и достоверной информации.

Ну и последний xseo.in.

Сведения по Гуглу правдивы, а вот Яндекс мне показали неточно.

Ну что ж. В целом – неплохо.

Индексация сайта в Яндексе

Что бы добавить сайт для индексации в Яндекс (Yandex.ru) достаточно вести его адрес в специальную форму addurl (англ. addurl — добавить URL). Вебмастера прозвали ее адурилкой. Находится она тут:

Для добавления сайта на индексацию достаточно ввести url главной страницы и капчу. Капча — это несколько цифр, которые защищают от автоматических регистраций. После того как вы нажмете кнопку «добавить» возможно несколько вариантов развития событий.

1) Сообщение «ваш сайт добавлен» сигнализирует об успешном добавлении ресурса в очередь на индексацию в Яндекс. 2) Если появилась надпись «Ваш хостинг не отвечает» — значит, ваш сервер лежит в этот момент. Можно попробовать добавить сайт позже или найти более качественный хостинг. 3) А вот если появилось сообщение, что «указанный URL запрещен к индексации» то дела плохи. Это говорит о том, что на ваш ресурс наложены санкции в виде бана сайта. Вполне возможно, что на купленном вами домене уже когда-то был сайт, который и получил санкции. При помощи addurl вебмастера часто проверяют сайты на бан в Яндексе.

Почему так важна проверка индексации сайта

Ваш сайт будет приносить прибыль, если уровень посещаемости его будет высоким, так как только этим можно заинтересовать рекламодателей.

Большая часть посетителей сайтов переходит на них по ссылкам из поисковиков, выдаваемым после введения запроса. Роботы поисковых систем проводят сверку запроса с информацией баз данных и выдает наиболее актуальные результаты. Попасть ресурсу в такую базу данных можно только после прохождения индексации поисковиком. Если сайт не проиндексировать или отдельные его страницы, то и потенциальный клиент никак не попадет на ваш ресурс.

Необходимо, чтобы поисковая система оперативно учитывала каждую новую страницу сайта, а не только весь ресурс. Оптимальный вариант – наличие внутренней перелинковки, обеспечивающей не только занесение новых данных в базу, но и обновление уже имеющихся по предоставляемым ссылкам.

Одним из факторов, влияющих на скорость индексации, является посещаемость ресурса. Но есть и другие.

Каждый день в Интернете появляются новые сайты, схожие по тематике с вашим. Они являются конкурентами, поскольку их контент дублирует содержимое вашего ресурса. С увеличением числа конкурирующих веб-страниц уникальность сайта падает. Причина этого – публикация в Сети материалов, представляющих собой рерайт уже имеющихся статей, поэтому так необходим учет поисковой системой уникального текста.

Оставить заявку

Также отсутствие индексации материалов сайта может стать причиной атаки ресурса мошенниками. Они могут скопировать ваш контент, выложить на своей странице и быстро проиндексировать его, таким образом заявив роботам поисковиков о своем авторстве. Впоследствии поисковые системы будут определять ваш контент как неуникальный, и это может стать причиной бана вашего ресурса.

В связи с этим так важен контроль индексации и ускорение ее проведения, особенно для молодых сайтов, только начинающих свое продвижение.

Рекомендуемые статьи по данной теме:

- Проверка скорости загрузки сайта: 14 лучших инструментов

- Проверка robots.txt: типичные ошибки и их устранение

- Файл htaccess: применение, включение, настройка

Robots.txt

Это файл, который можно отредактировать в любом текстовом редакторе. Преимущество и одновременно необходимость состоим в том, что он прописывает строгие инструкции для роботов поиска различных поисковых систем. Располагают роботс.тхт в корневой папке сайта.

Наиболее популярные ошибки, возникающие при работе с данным файлом:

-

закрытие действительно нужных страниц сайта. Чаще всего эта ошибка связана с незнанием всех аспектов и нюансов правильного заполнения;

-

использование кириллических символов в файле не допускается;

-

одни и те же правила для разных роботов. Нюанс, о котором часто забывают. Согласитесь, что даже на вид «Яндекс» и «Google» сильно отличаются друг от друга. Что тогда говорить о внутренних алгоритмах ранжирования и поисковых роботах?! Соответственно, и правила надо прописывать разные, так как один бот их примет, а другой даже не обратит внимания, а может и сразу уйдет, не завершив процесс индексирования.

-

использование директивы «crawl-delay» (определяет частоту запросов поискового бота и часто используется в тех случаях, когда сервер подвержен сильной нагрузке) без необходимости. Реальный пример: был сайт-визитка на самом дешевом хостинге. В него добавили каталог, содержащий около 10 000 товаров. Робот-поисковик начал скачивать и анализировать информацию и из-за ее объема стал не успевать ее обрабатывать. Многие страницы стали недоступны, выдавая 404-ую ошибку. Логичное решение – выставить директиву «crawl-delay». Поставили, все начало работать. Затем, в связи с разрастанием сайта, было решено перенести веб-ресурс на другой хостинг-провайдер, учтя при этом заранее параметры нагрузки сервера. Вроде все замечательно, а директиву «кроул» убрать забыли!!! В результате нагрузка на сервер минимальная, робот «не спешит» все обрабатывать и на выходе – очень долгое время индексации сайта.

Проверить файл с инструкциями для роботов можно, используя сервисы вебмастера от «Яндекс» или «Гугл». В «Yandex.Webmaster» достаточно зайти в раздел «Инструменты», затем в «анализ robots.txt». Загрузить файл и его вставить непосредственно в поле, посмотреть рекомендации или ошибки, которые необходимо будет исправить.

Зеркала

Это абсолютно идентичные копии друг друга. Самый яркий пример – главная страница сайта отображается, как по адресу «www.какой-то_сайт.рф», так и под доменным адресом с совпадающим именем без «www».

Наиболее распространенные ошибки, связанные с неправильной настройкой зеркал:

-

отсутствие указаний и директивы host в robots.txt или противоречащие друг другу указания;

-

перенаправление при переезде в уже имеющейся группе зеркал;

-

недоступность одного из зеркал, которая может возникнуть по различным причинам;

-

различающийся между собой контент на зеркальных страницах.

Как правильно сделать настройку зеркал при осуществлении переезда сайта на новое доменное имя:

1. следует сделать сайты с полными зеркалами, не забыв при этом прописать директиву host в файле роботс.тхт;

2. не забываем про вебмастер. Если рассматривать продукт от «Яндекса», то заходим все в тот же раздел «Индексирование», затем в «Переезд сайта», оповещая заранее поисковую систему о предстоящей процедуре;

3. Устанавливаем редирект на главное зеркало.

Дублирование

Подразумевает наличие нескольких идентичных страниц одного сайта, в которых содержится одинаковый контент.

Виды дублей:

-

страницы, адрес которых различается знаком «/». Например, «www.primer_saita.ru/Tovar/cart/GM928» и абсолютно аналогичный «…/GM928/». Часто встречается такая ситуация с карточкой одного и того же товара, которая относится к разным категориям (коньки, подходящие, как для девочек, так и для мальчиков);

-

дубли-страницы с незначащими параметрами, которые не воспринимает робот-поисковик. Примеры некоторых незначащих элементов для робота-поисковика, можно увидеть ниже:

Неприятности, которые могут возникнуть из-за дублей:

-

бот поисковой системы, вместо индексации необходимого и корректного адреса может посещать и анализировать множество ненужных страниц;

-

в базу данных поиска робот-анализатор может включить только одну страницу из всех возможных дублей, опираясь на свое усмотрение.

Как бороться с дублированными страницами:

Прописать атрибут rel= «canonical» тега со своим значением, то есть «выделить» страницу, расставив «приоритеты» цепочкой. Например, есть две страницы:

Допустим, что предпочитаемый адрес, который нам нужен – это вторая ссылка. Тогда, в первой странице необходимо прописать в ее html-коде следующую строчку:

Важно! Алгоритм анализа поисковым роботом устроен таким образом, что не считает данную директиву строгой, поэтому бот рассматривает ее, как предполагаемый вариант, который может быть проигнорирован!

-

«редирект 301», о котором мы уже говорили ранее. Особенно актуален в случаях дублей страниц с «/» и без него;

-

В файле robots.txt прописать параметры «disallow» (запрет доступа) и «clean-param» (учитывание динамических параметров (id сессий и др.), не влияющие на содержимое страницы). Пример таких дублей мы рассмотрели чуть ранее.

Где можно выявить дубли? Все в том же Вебмастере. В сервисе от «Яндекса» заходим в раздел «Индексирование», затем «Проверить статус URL», вводим ссылку, анализируем результат.

Что необходимо сделать для начала индексации нового сайта

Чтобы поисковые роботы начали индексировать сайт, необходимо:

- Убедиться, что индексация открыта в robots.txt.

Это довольно распространенная ошибка: новый сайт не открывают для индексирования в robots.txt. Эта опция по умолчанию присутствует в большинстве систем управления ресурсами.

Закрытый от индексации сайт можно узнать по наличию звездочки:

Удаление этого значка делает сайт доступным для поисковых роботов.

Строка Disallow позволяет скрыть служебные разделы и прочие страницы, которые не требуют индексации.

- Добавить сайт в поисковые системы.

Проще всего «открыть» сайт для поисковых систем – это добавление через формы, а также в Google webmaster tools и «Яндекс.Вебмастере».

- Поставить ссылки с других сайтов.

На новый сайт должны вести индексируемые ссылки с других ресурсов. При наличии уже работающего собственного сайта переходы обеспечиваются с него, а при создании самого первого ссылки покупаются на специальных биржах. Оптимальным вариантом будет задействование авторитетных ресурсов, которые регулярно обновляются.

Отличной индексацией могут похвастаться блоги и сайты СМИ. Ссылочные биржи – простой и надежный способ разместить на этих ресурсах ссылки, ведущие на новый сайт, тем самым способствуя его изучению поисковиками и включению в индекс.

- Ссылки из социальных сетей.

Положительно отражаются на индексации сайта прямые ссылки из соцсетей. Twitter, Facebook, Google Plus, YouTube – эти и многие другие площадки помогут «познакомить» поисковые системы с вашим ресурсом.

Для ожидаемого результата необходимо следить, чтобы ссылки были обязательно прямыми. Редирект, который задействован в социальной сети «Вконтакте», не позволит добиться индексации сайта.

- Добавление сайта в социальные закладки.

Ситуация со ссылками из социальных закладок, которые еще несколько лет назад были отличным вариантом, сегодня слегка изменилась, но не для всех сервисов.

К социальным закладкам относятся такие сайты, как: bobrdobr.ru, memori.qip.ru, moemesto.ru, mister-wong.ru и сотни подобных им. Их несомненное достоинство в том, что благодаря им ваш ресурс будет быстро обнаружен поисковыми роботами.

Конечно, индексация сайта в поисковиках будет максимально успешной, если одновременно применять все способы.

Оптимизация сайта – очень важный этап раскрутки, но все меры по продвижению не принесут успеха, если ресурс не индексируется поисковыми системами, поэтому этот вопрос необходимо решить в первую очередь.

Вас также может заинтересовать: Сайт закрыт от индексации: это не повод для паники

Semonitor

В одном из постов блога я писал уже про Semonitor, когда рассматривал программы для мониторинга обменных или купленных ссылок. Собственно, софт оказался весьма универсальным в плане проверки ссылок, там за это отвечает отдельный модуль Link Exchanger. От вас требуется ввести сайт на которые ставятся ссылки и из файла загрузить список url для проверки индексации страницы в поисковиках. После этого можно выбрать проверяемые параметры и запустить программу:

Безусловным плюсом в Semonitor есть то, что кроме проверки наличия ссылки вы сможете увидеть некоторые параметры проекта, анкор, количество внешних, внутренних ссылок, открытость ссылки для индексации и т.п. При большом числе запросов не обойтись без Yandex XML лимитов которые можете найти в своей учетной записи.

Ну и, конечно, результат проверки на 100% правильный, что также весьма радует. Даже и не знаю теперь, может не продавать Semonitor будет от него теперь хоть какая-то польза:) Нужно изучить остальные модули, там в принципе, полно опций и фишек для оптимизаторов.

А какими сервисами для проверки индексации страниц в поисковиках пользуетесь вы?

Как сохранить метку на карте

Проверка индексации страниц сайта в Яндексе через AddURL

Еще один способ, позволяющий узнать, попал ли в индекс определенная страница сайта, можно воспользоваться инструментом AddURL. Например, проверим, проиндексировался ли сайт в Яндекс. Для этого в аддурилке данной системы поиска вводим интересующий нас адрес страницы. После этого все станет ясно. Если страница уже находится в индексе, то будет выведена надпись «Указанный URL уже проиндексирован». Ну, а если ссылка еще не появилась в индексе, то напишет приблизительно следующее: «Адрес такой-то успешно добавлен. Его индексация и добавление в поиск будут осуществлены по мере обхода робота». Все это правдиво лишь в том случае, если вы не установили запрет для индексации вашего сайта.

Данный метод – достаточно неплох, однако, придется тратить время на неоднократное введение капчи.

Используем панель Вебмастера

Каждая поисковая система имеет свою панель инструментов, специально предназначенную для вебмастеров. С помощью этой панели можно увидеть общее количество проиндексированных страниц. Рассмотрим на примере самых популярных ПС (Яндекс и Google), как выполнять такую проверку.

Чтобы использовать панель инструментов Яндекс в данном контексте, нужно завести аккаунт (если его еще нет), зайти в панель и добавить в нее свой сайт. Там будет показано общее количество страниц, которые уже проиндексированы.

Для использования панели инструментов Google также нужно обзавестись аккаунтом, чтобы иметь возможность зайти в панель. В нее нужно добавить свой сайт и зайти на вкладку «Состояние / Статус индексирования». Здесь также будет показано количество проиндексированных страниц.

Нередко можно заметить, что панель Вебмастера Google может показать значительно большее количество проиндексированных страниц, чем панель инструментов Яндекс. Представим, что на сайте 70 уникальных страниц, которые проиндексировались. И, скажем, Яндекс насчитал приблизительно такое количество ссылок, а Гугл, например, 210. Получается, что Яндекс показал правильное число, а Гугл в 3 раза больше. Так в чем же дело? А дело в дублях страниц, генерируемых движком WordPress. Такие дубли поисковикам не по душе. Использование robots.txt позволяет игнорировать индексацию дублей страниц поисковыми системами. И если на Яндекс это действует, то с Гуглом в этом плане могут возникать проблемы, так как он может действовать по своему усмотрению.

Есть также специальный сервис Pr-cy.ru, позволяющий получить вебмастерам различные данные по сайтам – в том числе, число страниц, проиндексированных в Гугле и Яндексе. Чтобы узнать эту информацию, нужно посмотреть на две нижние колонки соответствующих поисковых систем.

Что помогает ускорить индексацию сайта

Чтобы страницы быстрее индексировались, нужно придерживаться главных правил:

Регулярное размещение уникальных и оптимизированных статей. Поисковый робот возьмет себе за привычку регулярно посещать тот сайт, на котором с определенной периодичностью размещается качественный, полезный и интересный контент.

Анонсирование о размещении нового контента или полезных обновлениях на сайте через социальные сети. После того, как появилась статья, можно самостоятельно сообщить об этом в социальную сеть с помощью кнопки retweet. Поисковый бот отметит это и зайдет на сайт через социальную сеть значительно быстрее.

Поисковому роботу гораздо проще найти конкретную страницу с помощью ссылки, имеющейся на вашем сайте

То есть, не стоит забывать о важности внутренней перелинковки.

Добавив xml-карту в панель вебмастера, мы даем возможность поисковому боту пройти по ней. Также ее нужно добавить в robots.txt

Полезна и карта сайта (карта для человека), по которой бот отыщет все страницы сайта.

В материале мы рассмотрели основные способы, позволяющие проверить, попали ли страницы сайта в индекс различных поисковых систем. Некоторые из них более эффективные, а какие-то – менее, но каждый из них имеет право на существование и использование.

Читайте далее:

Методы ускорения индексации сайта в яндексе

Seo — проверка индексации текста и веса ссылок тест

Быстрая индексация сайта в Гугле

Индексация ссылок

Проверить картинки на уникальность

Как скрыть персональные данные в поисковых системах?

Различия индексации сайта в Google и «Яндексе»

Основное различие поисковых систем «Гугл» и «Яндекс» заключается в региональной принадлежности. Если Yandex работает только в русскоязычной части Интернета, то Google является международным поисковиком. Свои системы поиска есть практически в каждой стране. В некоторых случаях региональные сервисы могут составлять серьезную конкуренцию «Гуглу» («Яндекс» в РФ, Seznam – в Чехии, Baidu – в КНР и т. д.). Подтверждением этого факта могут служить переговоры по вопросам выкупа сервиса Yandex компанией «Гугл», которые имели место в 2003 году. Пока такое поглощение не состоялось.

У каждой поисковой системы есть свои программы ботов, осуществляющие проверку сайтов на предмет релевантности и качества представленного на них контента. При этом стандарты работы таких роботов постоянно совершенствуются. Нужно отметить, что разработчики не открывают полностью суть алгоритмов индексации, поэтому специалисты постоянно анализируют поисковые программы и на основании имеющихся практических данных формируют определенные выводы.

Рекомендуемые статьи по данной теме:

- Внутренняя оптимизация сайта: пошаговый разбор

- Проверка robots.txt: типичные ошибки и их устранение

- Редирект с http на https: повышаем безопасность сайта

Требования, которые предъявляют «Гугл» и «Яндекс» к индексации сайтов, имеют много общего. Поэтому можно сформулировать некоторые универсальные рекомендации:

Нужно уделять больше внимание качеству контента (уникальность, полезность и грамотность)

Программные и орфографические ошибки четко отслеживаются ботами и снижают индекс авторитетности сайта.

Интернет-площадки должны иметь понятную структуру

Важно, чтобы они были удобными для пользователей и содержали важную и ценную информацию.

Следует качественно проработать страницы контактов и обратной связи, разместить портфолио и отзывы, а также описать имеющиеся достижения.

На сайте нужно разместить работающие исходящие ссылки.

Контент на интернет-площадках должен постоянно обновляться, а их функционал следует дорабатывать с учетом различных нововведений и инноваций. Все это учитывается поисковиками при ранжировании сайтов.

Поисковая система «Яндекса» имеет два робота – основной и быстрый (Orange). Первый осуществляет индексацию Сети в целом, а второй обеспечивает возможность быстрого поиска наиболее свежей и актуальной информации по запросу пользователя. Каждый робот имеет перечень данных, которые необходимо проиндексировать.

По мнению экспертов, «Яндекс» работает медленнее, чем «Гугл». Но при этом поисковая система Рунета индексирует полезные материалы и исключает из выдачи «лишние» результаты.

Преимущество «Гугла» заключается в его универсальности. «Яндекс» же развивается исключительно в русскоязычном Интернете (попытки выйти на другие рынки имели место, но пока не увенчались успехом).

Система Yandex ориентирована на поиск по запросам из ограниченного перечня регионов. Но именно региональный характер во многом определяет его успешность. В настоящее время «Гугл» и «Яндекс» занимают в русскоязычном Интернете примерно одинаковые ниши.

В интернет-пространстве других стран поисковая система Yandex не получила распространение, так как наиболее значимыми факторами поиска там выступают язык и местонахождение пользователя. На основании этих критериев и строится поисковая выдача «Гугла». В системе «Яндекс» индексация по языковым признакам не происходит. Несмотря на то, что этот поисковик определяет место нахождения пользователя, он не учитывает этот фактор при обработке запроса. Классифицировать сайты Рунета по регионам в зависимости от языка запроса не получается. «Яндекс» может настраивать поисковую выдачу исключительно по территориальному признаку, в чем и заключается уникальность этой системы.

Не так давно Yandex запустил новый инструмент – поиск «Андромеда». После этого поисковик предлагает определенные места в городах, дает возможность собирать коллекции пользователя, информирует о событиях из мира спорта, отмечает статус интернет-ресурсов особыми значками в зависимости от их благонадежности и популярности. Каким образом новый инструмент может влиять на индексацию, еще не совсем ясно.

Важным нововведением 2018 года является замена показателя ТИЦ (индекс цитирования) на ИКС (индекс качества сайта). Новый показатель необходимо учитывать при продвижении ресурса.

Мир

Проверка индексации

Чтобы обнаружить «мусорные страницы», нужно следовать следующему алгоритму:

- Получаем полный список страниц, которые должны быть проиндексированы. Для этого мы используем программу Screaming Frog SEO Spider. При правильной настройке файла robots.txt спарсится список всех доступных для индексации страниц.

- Выгружаем индексируемые страницы сайта из Вебмастеров.

- Сравниваем попарно получившиеся списки с помощью инструмента «Условное форматирование» в Excel, подсветив все уникальные значения.

В ходе сравнения могут возникнуть следующие ситуации:

- подсветка страниц, которые есть только в списке парсера. В таком случае нужно диагностировать причину, почему страница не находится в индексе. Если она должна индексироваться, то отправляем ее на переобход. Как это делать, описано в статье.

- подсветка страниц, которые есть только в индексе. В данном случае пытаемся понять, почему ее нет в списке всех страниц сайта. Возможно, это страница с кодом 404, которая так и не была удалена поисковым роботом или деактивированный элемент, у которого неверно настроен код ответа.

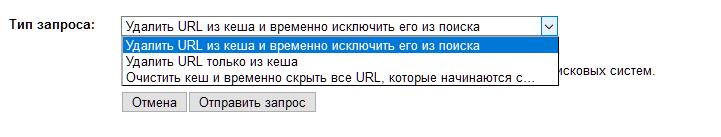

Для удаления страниц в Вебмастере существует инструмент «Удаление страниц из поиска», позволяющий единовременно удалить до 500 отдельных страниц или группу страниц по префиксу в url. Главное, чтобы страницы были закрыты от индексации.

Инструмента для принудительного удаления страниц у Google нет, но можно временно удалить свои URL из результатов поиска.

Для этого необходимо зайти в старую версию Search Console и в левом меню выбрать «Индекс Google» > «Удалить URL-адреса».

Далее указываем URL страницы, которую вы хотите скрыть. Выбираем из списка необходимое действие и отправляем запрос.

Инструмент проверки индексации от PromoPult

Для быстрой проверки индексации онлайн в Яндексе и Google в PromoPult разработали инструмент для анализа индексации страниц.

Что он умеет:

- одновременно проверять проиндексированные страницы в Яндексе и Google (или только одной из тих ПС);

- проверять сразу все URL сайта из XML-карты;

Особенности инструмента:

- работа «в облаке»;

- выгрузка отчетов в формате XLSX;

- уведомление на почту об окончании сбора данных;

- хранение отчетов неограниченное время на сервере PromoPult;

- нет ограничений по количеству URL.

Как проверить индексацию страниц с помощью инструмента PromoPult

Шаг 1. Добавьте URL на проверку

Перейдите на страницу инструмента и добавьте URL, которые нужно проверить. Делается это одним из трех способов:

Добавление XML-карты сайта (вариант подходит, если вам нужно проверить все URL сайта; для этого укажите полный путь к карте сайта в формате http://www.site.ru/sitemap.xml).

Загрузка XLSX-файла (в этом случае система проверит все URL, указанные на первом листе сайта; расположение URL по столбцам и строкам не имеет значения).

Добавление списка URL вручную (вариант подходит, если вам нужно проверить не все URL сайта, а только некоторые из них; каждый URL прописывайте с новой строки).

В зависимости от того, из какого источника вы будете брать URL, решаются разные задачи.

Из XML-карты сайта или CMS

В этом случае можно проверить, какие из важных URL не проиндексированы.

Пример. В карте сайта 1250 URL, которые подлежат индексации. Мы вводим поочередно в Яндексе и Google команду:

site:yourdomain.ru

Получаем количество проиндексированных страниц – 684 и 1090.

Задача – определить, каких страниц не хватает. Сканируем XML-карту сайта с помощью инструмента от PromoPult, получаем информацию по всем URL и выявляем несоответствия.

Из отчета о проиндексированных страницах из Яндекс.Вебмастера или Google Search Consol

Бывает, что в каком-то поисковике количество проиндексированных страниц превышает количество URL в карте сайта. В такой ситуации необходимо загрузить на проверку все URL из поисковика, в котором наблюдается такое превышение, – это позволит выявить «лишние» страницы.

Пример. В карте сайта 15 570 URL, которые подлежат индексации. Проверяем количество страниц по команде site:yourdomain.ru в Яндексе и Google:

В Яндексе количество страниц превышает количество страниц не только в Google, но и в карте сайта. Очевидно, что в индекс попали нежелательные страницы. Если запустить проверку только по URL из карты, мы так и не узнаем, какие URL «лишние». Поэтому переходим в Яндекс.Вебмастер, выгружаем все страницы из поиска и проверяем их. Теперь проще разобраться, в чем проблема.

На данном этапе выберите ПС для проверки индексации. Для выявления расхождений выберите две системы.

Шаг 3. Загрузка отчета

После проверки отчет появится в «Списке задач». Кроме того, вам на почту придет уведомление:

Загрузите отчет в формате XLSX:

В файле два листа: результаты анализа и исходные данные. На первом листе 3 столбца: URL и данные по индексации (1 – страница проиндексирована, 0 – нет).

С помощью автофильтра вы легко определите, каких страниц не хватает в Яндексе или Google:

Тестируем Google

Забугорный поисковик в России любят не так сильно, как кажущийся уже родным Yandex. Однако для веб-мастера Google – это кладезь полезной статистики. Страницы держатся в двух выдачах:

главной – здесь оказываются только качественные площадки, участвующие в дальнейшем ранжировании;

дополнительной – тут сохраняются технические раздели и копии главных страниц.

Введя запрос site:ваш_сайт, вы получите эффективность в обеих выдачах. Кроме того, воспользуйтесь вебмастером https://www.google.com/webmasters/#?modal_active=none.

Что делают с полученной статистикой

Идеально, если численность страниц сайта совпадает с количеством полностью проработанных. Но такое случается редко. Чаще всего события развиваются по двум сценариям:

- численность проиндексированных элементов меньше. Из-за этого уходит трафик, всё остальное пользователь попросту не видит.

- Число проиндексированных страниц больше, чем их есть на самом деле. Только рано бить в барабаны и прыгать до потолка от радости. Роботы читают повторяющийся материал, и продвижение идёт хуже.

Возникают такие проблемы? Незамедлительно действуйте! В противном случае вложенные усилия пойдут коту под хвост.

Большие деньги вы получите только в розовых мечтах. Придётся проверять всё, что у вас есть. Это утомительно, но по-другому никак.

Как управлять поисковым роботом

Поисковая система скачивает информацию с сайта, учитывая robots.txt и sitemap. И именно там вы можете порекомендовать поисковику, что и как скачивать или не скачивать на вашем сайте.

Файл robots.txt

Это обычный текстовый файл, в котором указаны основные сведения — например, к каким поисковым роботам мы обращаемся (User-agent) и что запрещаем сканировать (Disallow).

Указания в robots.txt помогают поисковым роботам сориентироваться и не тратить свои ресурсы на сканирование маловажных страниц (например, системных файлов, страниц авторизации, содержимого корзины и т. д.). Например, строка Disallow:/admin запретит поисковым роботам просматривать страницы, URL которых начинается со слова admin, а Disallow:/*.pdf$ закроет им доступ к PDF-файлам на сайте.

Также в robots.txt стоит обязательно указать адрес карты сайта, чтобы указать поисковым роботам ее местоположение.

Чтобы проверить корректность robots.txt, загрузите его в специальную форму на странице Яндекс.Вебмастер или воспользуйтесь отдельным инструментом в .

Файл Sitemap

Еще один файл, который поможет вам оптимизировать процесс сканирования сайта поисковыми роботами ― это карта сайта (Sitemap). В ней указывают, как организован контент на сайте, какие страницы подлежат индексации и как часто информация на них обновляется.

Если на вашем сайте несколько страниц, поисковик наверняка обнаружит их сам. Но когда у сайта миллионы страниц, ему приходится выбирать, какие из них сканировать и как часто. И тогда карта сайта помогает в их приоритезации среди прочих других факторов.

Также сайты, для которых очень важен мультимедийный или новостной контент, могут улучшить процесс индексации благодаря созданию отдельных карт сайта для каждого типа контента. Отдельные карты для видео также могут сообщить поисковикам о продолжительности видеоряда, типе файла и условиях лицензирования. Карты для изображений ― что изображено, какой тип файла и т. д. Для новостей ― дату публикации. название статьи и издания.

Чтобы ни одна важная страница вашего сайта не осталась без внимания поискового робота, в игру вступают навигация в меню, «хлебные крошки», внутренняя перелинковка. Но если у вас есть страница, на которую не ведут ни внешние, ни внутренние ссылки, то обнаружить ее поможет именно карта сайта.

А еще в Sitemap можно указать:

- частоту обновления конкретной страницы — тегом <changefreq>;

- каноническую версию страницы ― атрибутом rel=canonical;

- версии страниц на других языках ― атрибутом hreflang.

Карта сайта также здорово помогает разобраться, почему возникают сложности при индексации вашего сайта. Например, если сайт очень большой, то там создается много карт сайта с разбивкой по категориям или типам страниц. И тогда в консоли легче понять, какие именно страницы не индексируются и дальше разбираться уже с ними.

Проверить правильность файла Sitemap можно на странице Яндекс.Вебмастер, а также в Google Search Console вашего сайта в разделе «Файлы Sitemap».

Итак, ваш сайт отправлен на индексацию, robots.txt и sitemap проверены, пора узнать, как прошло индексирование сайта и что поисковая система нашла на ресурсе.

Что такое апдейт?

Слово апдейт от английского update, что в переводе означает:

- модернизация,

- свежие новости,

- модернизировать,

- обновлять.

В контексте поисковых систем более всего соответствует слово – обновлять, т.е. апдейт – это обновление базы поисковой системы.

Что происходит во время апдейта?

Для того, чтобы сайт участвовал в поиске, чтобы поисковая система могла показать его своим посетителям, она в первую очередь должна знать о его существовании. Для этого существует робот-паук, который постоянно сканирует интернет, и база, в которую робот помещает новые найденные ресурсы. Но происходит это (помещение сайта в базу) не сразу.

Сначала робот только собирает информацию. Можно представить это, как мы, блоггеры, собираем новую информацию, держим ее в голове, прежде, чем напишем о полученных знаниях в своем блоге. Когда собрано достаточное количество новой информации, приходит время ее поместить в базу. Но новую информацию нельзя просто взять и поместить. Необходимо всю базу перестроить с учетом новой информации. Ведь, как мы знаем, все сайты ранжируются по сложнейшему алгоритму, в котором учитывается большое количество факторов. Чтобы правильно учесть новые сайты в своей базе, чтобы у них так же появилась возможность участвовать в ранжировании, необходимо и новые и старые ресурсы перестроить.

Именно формирование новой базы и называется апдейтом.

Что входит в обновление поисковой базы

Во время апдейта учитываются новые тексты, которые нашел робот-паук, новые ссылки, изменения, которые произошли на уже проиндексированных сайтах.

Стоит сказать, что апдейты есть у каждой поисковой системы, но если у одних, например, у Google, апдейты проходят чаще и, почти, незаметно, то у других, как в случае с Яндексом — это целое событие.

Заключение

Для того, чтобы ваш сайт хорошо индексировался, вы должны соблюдать совсем несложные требования. Нужно просто добавить его в Яндекс Вебмастер и Search Console, следить за регулярным выходом качественных материалов, своевременно исправлять ошибки и не нарушать правил.

Все это гарант того, что ваш проект будет на хорошем счету у роботов. А это, в свою очередь, будет иметь материальное значение. Ваши статьи будут выше в выдаче, дохода будет больше.

Некоторым новичкам бывает очень сложно разобраться со всеми тонкостями SEO-оптимизации. Очень много разной информации и не всегда она правильная. Если вы один из таких новичков, то я рекомендую вам пройти курс Василия Блинова “Как создать сайт”.

Из материалов с этого курса вы сможете узнать о том, как создать собственный информационный проект под монетизацию. Там рассмотрены наиболее важные нюансы, которые должен учитывать каждый вебмастер.